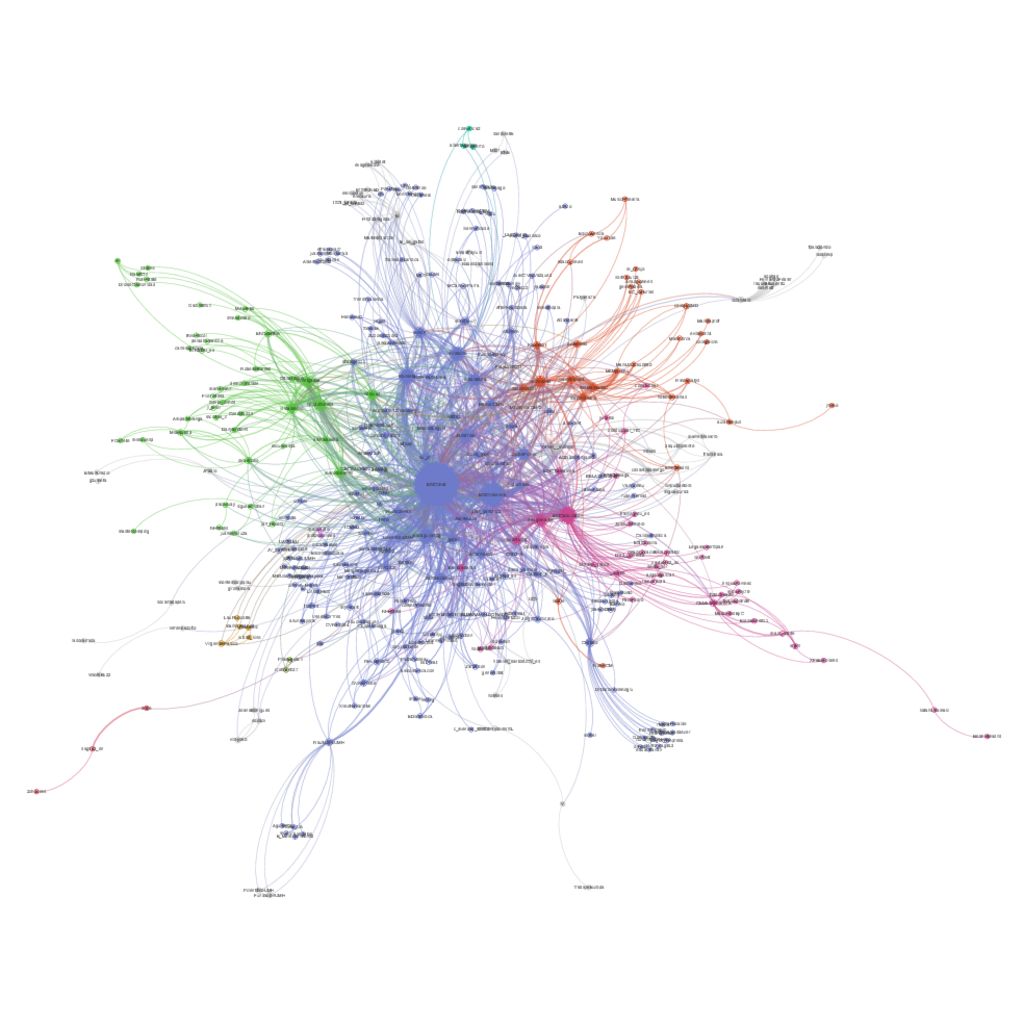

O al menos sin compartirlos a desconocidos. Los procesos de consenso en redes permiten hacer cálculos de forma descentralizada trabajando con información local (privada) y compartiéndolo solo con los contactos directos.

En estos días se ha hablado mucho del modelo chino y coreano y de cómo estos países han logrado controlar la expación del SARS-CoV-2 (en adelante coronavirus, que ya es casi como de la familia). Una de las medidas estrella ha sido una aplicación móvil que ha usado el gobierno de Corea del Sur para hacer un seguimiento de la infección y controlar a los pacientes. Usando un código de color para identificar el riesgo y con medidas estrictas para las personas infectadas, han conseguido frenar la fase de crecimiento de la enfermedad, y por lo visto mejor que nosotros.

Continuar leyendo «Cómo calcular el riesgo de infección por coronavirus sin compartir datos de salud privados»