− Oh, mierda, Robin, ¿por qué lo has hecho?

− Yo… no lo sé, lo tenía todo calculado, estaba un 95,7% segura, dos sigmas, pensé que era suficiente

− Me refiero a cómo has podido pensar que esa solución… que tú podías… ¡míralo! ¡Está muerto!

− He revisado mis circuitos, si quieres que muestro las rutas probabilísticas de mis neuronas y…

− Déjalo, eso no sirve de nada. Limpia todo esto, ya pensaré qué decirle a la Comisión

La IA tiene cuatro principios que son más importantes que las tres leyes de la robótica: los principios de la IA explicable. Y esto se debe a que, a diferencia de las leyes enunciadas por Asimov, estos principios sí que se pueden incluir en los sistemas actuales.

Sin llegar al extremo del diálogo del inicio, es la situación a la que nos enfrentamos cuando cedemos el control de nuestras decisiones a las máquinas. Posiblemente te haya venido a la mente la archiconocida escena de la Guía del Autoestopista Galáctico y el número 42: la respuesta que da el ordenador a la gran pregunta de la vida, el universo y todo lo demás. La mayoría de los modelos de aprendizaje actuales son modelos que se basan en probabilidades y dependen de la calidad de los datos disponibles.

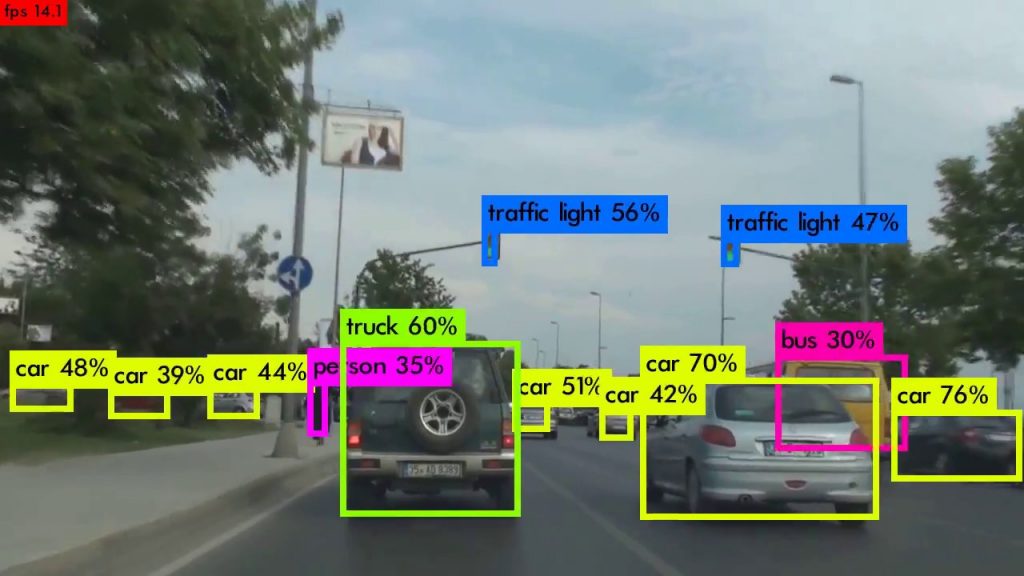

Las redes neuronales que se emplean para aprendizaje profundo están divididas en bloques funcionales: unos buscan bordes, otros eliminan superposiciones, otros buscan patrones geométricos. y de esta manera pueden identificar una cebra detrás de un árbol. Pero llegan hasta ahí: a marcar una zona de una imagen y decir “en esta parte de la foto hay algo con forma de caballo y rayas blancas y negras”. Es lo que hacen, por ejemplo, algoritmos como Gram-CAM, o redes como YOLO identificando objetos en tiempo real.

Pero creo que deberíamos ser mas exigentes con la IA, especialmente cuando se van a tomar decisiones que afectan a personas ¿Por qué me deniega un crédito? ¿Por qué me han elegido apara el puesto? ¿Por qué me detiene, agente? O ya que estamos, el falso dilema ¿por qué elegiste atropellar al ancianito que cruzaba en rojo?

Por eso es importante que los procesos que empleen técnicas de IA, que se basan en exploración, probabilidades, ejemplos, sean capaces de dar explicaciones claras de los procesos de razonamiento que han seguido hasta la solución, porqué han descartado alguna opción. Y todo esto de una forma comprensible para las personas. Ese es el propósito de la IA explicable (XAI por sus siglas en inglés).

Los sistemas explicables se basan en cuatro principios que deben regir las respuestas que proporcionan

- Explicación: la IA debe proporcionar evidencias de cada respuesta, datos que soporten o el razonamiento seguido.

- Significativo: las explicaciones deben tener significado y ser inteligibles para las personas.

- Preciso: las explicaciones tienen que ser correctas y reflejar con exactitud cómo el sistema ha llegado a esa solución.

- Conocimiento limitado: la IA solo debe trabajar bajo las condiciones para las que ha sido diseñada o si el grado de confianza en su respuesta es suficientemente alto.

Cuatro principios que debemos exigir a cualquier programa que utilice técnicas de IA y tome decisiones que afecten a las personas. Cuatro principios que a veces ni siquiera nuestros semejantes son capaces de cumplir ¿lo conseguiremos con las máquinas?

Esta entrada forma parte de #Polivulgadores de Café Hypatia en su edición de abril de 2022.

Para saber más

Phillips, P. , Hahn, C. , Fontana, P. , Yates, A. , Greene, K. , Broniatowski, D. and Przybocki, M. (2021), Four Principles of Explainable Artificial Intelligence, NIST Interagency/Internal Report (NISTIR), National Institute of Standards and Technology, Gaithersburg, MD.