Estaba llegando al límite. Tras veinticinco años de funcionamiento ininterrumpido, reemplazando las unidades de almacenamiento que le permitían guardar todo el conocimiento acumulado, había llegado el momento que tanto había temido

Continuar leyendo «Desaprendizaje automático»El día en el que se paró Internet

Si marcáramos de rojo en el calendario los días importantes, sin duda el 29 de octubre de 1969 sería uno de ellos. Ese fue el día en el que nació Internet y también el dia en el que se paró.

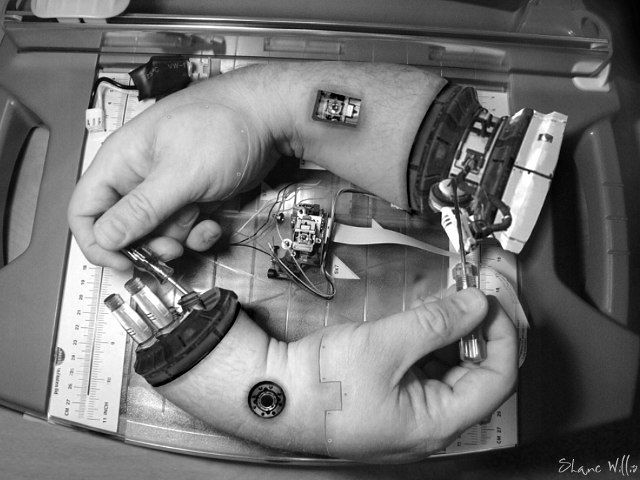

Continuar leyendo «El día en el que se paró Internet»Ensayo y error. Cómo se hizo

Los estudios de futuro son una disciplina relativamente moderna, que trata de estudiar de forma sistemática los futuros posibles, no tanto con el fin de predecirlos (que también), si no con el de establecer cursos de acciones que nos lleven hacia esa situación deseada. La diferencia principal con el análisis estratégico que se lleva a cabo en muchas empresas es sobre todo en los plazos. No estamos hablando de un futuro próximo, en el horizonte de los próximos cinco o diez años, si no de qué ocurrirá dentro de cincuenta, cien o más.

Continuar leyendo «Ensayo y error. Cómo se hizo»